Computer è una parola di derivazione latina che sta per computare, calcolare. Per computer, quindi, si intende un calcolatore automatico in grado di eseguire istruzioni, fornite sotto forma di istruzioni logico-aritmetiche, e di restituire i risultati di tale operazioni in seguito ad un processo di elaborazione. Quale che sia la definizione esatta (difficile da dare, comunque), cosa rappresenti oggi un computer lo sappiamo tutti, perché tutti almeno una volta nella vita abbiamo avuto a che fare con uno di questi dispositivi.

Anche voi, per leggere questo articolo, state facendo molto probabilmente uso di un PC. Anzi, è probabile che la gran parte di voi utilizzino un computer o per lavoro o per studio. Quindi, al di là della definizione, sappiamo tutti cosa è un computer e quali cosa possa e non possa fare. Ciò che resta oscuro ai più è la storia di questi dispositivi, quali siano stati i primi computer e come si sono evoluti nel tempo.

Cosa sono i computer

Innanzitutto, vista la definizione piuttosto ampia data all'inizio, all'interno della categoria di computer possiamo far rientrare un gran numero di dispositivi che mai penseremmo possano essere accumunati ai PC che abbiamo in casa. Così, ripercorrendo all'indietro la storia dell'uomo, scopriamo che i computer hanno antenati insospettabili. Come ad esempio l'abaco, gli astrolabi o gli orologi astronomici realizzati in Cina attorno all'anno mille.

I primi calcolatori meccanici del Rinascimento

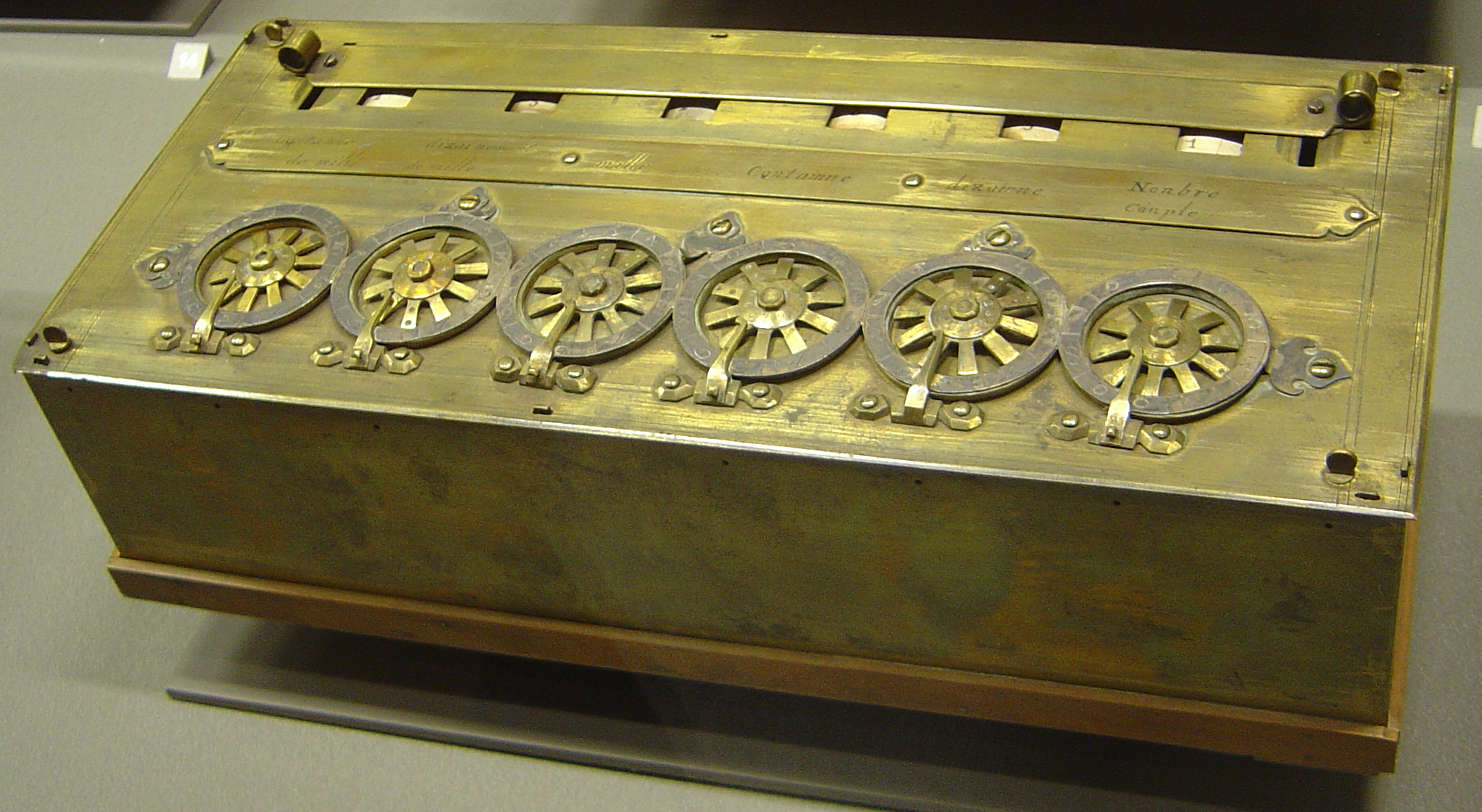

Molto più sofisticati (e infatti ci spostiamo molto più avanti nel tempo) sono i Bastoncini di Nepero (detti anche Ossi di Nepero), realizzati nella prima metà del XVII secolo dal matematico scozzese Nepero, che permettevano di effettuare complicate moltiplicazioni alla stregua di moderne calcolatrici. Nella seconda metà del 1600, invece, si arrivò alla meccanizzazione delle operazioni matematiche fondamentali (addizione, sottrazione, moltiplicazione e divisione) grazie alla collaborazione – a distanza – di due grandi filosofi del passato: lo svizzero Pascal e il tedesco Leibniz. Il primo, a cavallo tra 1640 e 1660, realizzò una ventina di esemplari di Pascalina, calcolatore meccanico in grado di effettuare addizioni e sottrazioni. Leibniz, una trentina di anni dopo, riuscì a migliorare la Pascalina, riuscendo a creare lo Stepped Reckoner, un calcolatore in grado di moltiplicare e dividere automaticamente.

Calcolatori industriali, macchina differenziale e macchina analitica

Nel 1800 la teoria computazionale venne applicata all'industria manifatturiera. Nel 1801, il francese Joseph-Marie Jacquard iniziò a utilizzare all'interno delle sue industrie un telaio semi-meccanizzato controllato da schede perforate. La trama e l'ordito dei tessuti prodotti era dettato direttamente da queste schede, che potevano essere cambiate senza dover cambiare "l'hardware" di supporto (in questo caso il telaio), esattamente come accade con i moderni software per computer.

A ridosso della metà del 1800, l'inglese Charles Babbage sviluppò dapprima la Macchina differenziale, capace di svolgere complicate funzioni polinomiche, e successivamente la Macchina analitica, primo vero prototipo di un computer meccanico in grado di svolgere svariati compiti oltre i calcoli matematici e programmabile attraverso schede perforate. La macchina doveva essere alimentata da un motore a vapore ed era dotata di una memoria interna, capace di contenere sino a 1000 numeri di 50 cifre ognuno, e di un processore per l'analisi dei dati di input. Babbage non fu mai in grado di realizzarne un esemplare – dalle mastodontiche dimensioni di 30 metri di lunghezza e 10 metri di profondità – a causa degli scarsi fondi a disposizione del matematico e filosofo britannico. Ma, grazie alle preziosi intuizioni di Babbage, la strada per i calcolatori meccanici era ormai spianata e la storia dei computer iniziò a muovere i suoi primi, fondamentali, passi.

von Neuman e Turing, i progenitori dell'informatica moderna

Prima di arrivare ai computer elettronici e digitali, comunque, dovrà passare quasi un secolo e, soprattutto, fu necessario che il matematico inglese Alan Turing teorizzasse il funzionamento della cosiddetta Macchina di Turing. Questo dispositivo, prettamente ideale, processa i dati salvati su un nastro infinito (nel 1936, anno in cui Turing teorizzava la composizione della sua Macchina, i dati venivano salvati su bobine magnetiche simili alle nostre audiocassette) secondo un insieme definito di regole. Partendo da questo teorema, John von Neuman descrisse l'architettura di un calcolatore, composto da un processore centrale, un'unità di memoria su cui sono salvati sia i dati di input che i dati di output, e un bus che collega tutte le parti tra loro. In sostanza, tutti i moderni computer sono ancora basati sulla Macchina di Turing e sull'Architettura di von Neuman.

Z1 e Colossus, i primi computer programmabili

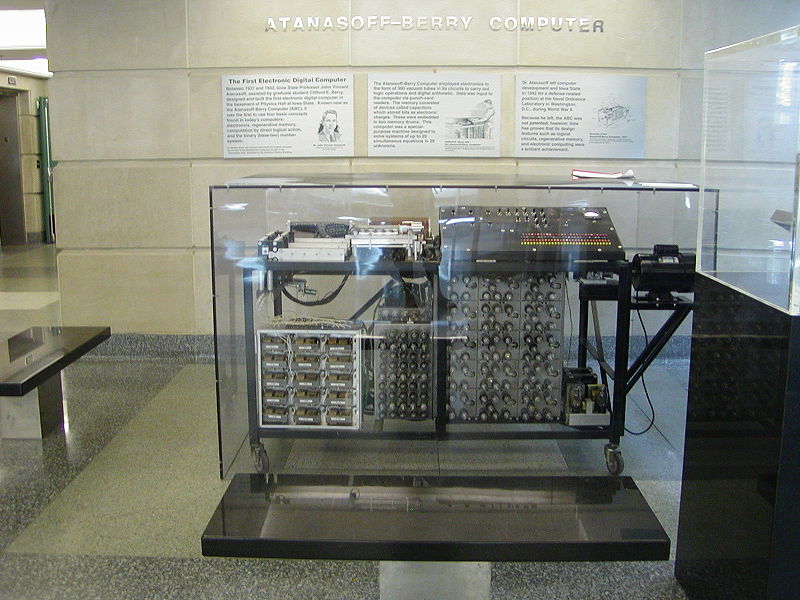

Il primo computer programmabile, lo Z1, venne realizzato dal tedesco Konrad Zuse tra il 1936 e il 1938 nella sala da pranzo dei suoi genitori nella Germania nazista. È di cinque anni successivo, invece, il Colossus, calcolatore elettronico programmabile realizzato dalle forze armate britanniche nel tentativo di decriptare il codice Enigma. Ma nella corsa all'informatizzazione digitale non poteva di certo mancare la nascente potenza mondiale degli Stati Uniti. Tra la fine del 1930 e l'inizio del 1940 vennero realizzati l'Atanasoff-Berry Computer (ABC), il primo computer digitale elettronico della storia, e l'ENIAC (Electronic Numerical Integrator And Computer), primo computer general purpose della storia, grande "appena" 167 metri quadri e pesante 27 tonnellate.

Computer a transistor

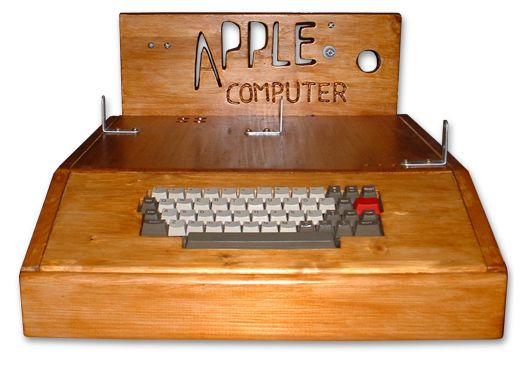

Nell'immediato dopoguerra, l'informatica conobbe un impressionante sviluppo, grazie soprattutto all'invenzione dei transistor che permisero di ridurre peso e dimensioni delle macchine. Il più famoso computer della cosiddetta seconda generazione dell'informatica fu l'IBM 1401, presentato al mondo nel dicembre del 1959. Negli anni '60 si entrò nella terza generazione dell'informatica grazie alla scoperta dei circuiti integrati, comunemente conosciuti come microchip, che portò alla creazione dei microprocessori. Con i computer di quarta generazione – inizio anni '70 – si entra nel campo dei cosiddetti microcomputer e ci avviciniamo a grandi falcate verso la "nostra" informatica. I primi microcomputer – tra i quali l'Altair 8800 e l'Apple I – permisero al grande pubblico di avvicinarsi al mondo dell'informatica: sempre più piccoli e sempre più "economici", iniziarono a varcare le porte delle prime abitazioni e diventare complementi d'arredamento di molti salotti statunitensi.

Il boom dell'informatica commerciale

Negli anni '80 sbarcano nel mondo dell'informatica l'interfaccia grafica e il mouse, inizialmente progettati e realizzati da Xerox e successivamente adottati dalla Apple nel Macintosh, il primo computer dedicato alle "masse" dotato di interfaccia grafica ad oggetti. In quegli anni si iniziò a diffondere l'idea di poter realizzare computer "portatili", ovvero dotati di una fonte di energia interna e di un monitor. Utilizzabili quindi ovunque, anche per strada. Il Compaq Portable fu il primo computer di questo tipo, antenato di tutti i laptop che utilizziamo oggi.

Oltre la Legge di Moore

Il mondo dell'informatica, per come lo conosciamo oggi, sembra essere destinato a cambiare radicalmente nel giro di qualche anno. La Legge di Moore, che ha stabilito le tappe dello sviluppo dei transistor e dei processori negli ultimi 50 anni, si avvia lentamente verso il capolinea. Ciò vuol dire che i produttori di chip dovranno ben presto trovare e adottare altre tecnologie costruttive che rendano possibile realizzare CPU (e altre componenti elettroniche) sempre più potenti e performanti. Diverse le opzioni presenti sul tavolo: dai chip 3D al diodo termico, passando per i chip fotonici e i nanofogli.

- Chip 3D. Come lascia intendere il nome, si tratta di chip in cui allo sviluppo in larghezza e lunghezza, si unisce anche quello in altezza. Merito di una modifica delle porte di comunicazione, che consente di realizzare transistor comunicanti su tutti i lati, anziché solo su due. In questo modo sarà possibile continuare a far crescere il numero di transistor presenti all'interno della stessa superficie, rispettando a pieno i dettami della Legge di Moore

- Diodo termico. Elemento base della caloritronica (settore affine all'elettronica), il diodo termico è l'equivalente "calorico" di un transistor elettrico. Come in un chip "usuale" la corrente scorre solo in un verso, anche in un diodo elettrico il calore viaggia solamente in una direzione: ciò potrebbe consentire di realizzare chip nei quali le informazioni sono fatte viaggiare attraverso il calore. Al momento, però, i diodi termici hanno trovato applicazioni solo all'interno dei laboratori di ricerca e sviluppo della Scuola Normale di Pisa: nel caso potessero essere utilizzati anche per realizzare dei chip informatici, sarebbe possibile costruire dei PC ad alta efficienza energetica e calorica, caratterizzati da una dispersione minima dell'energia

- Chip fotonici. Oltre agli elettroni e al calore, c'è un terzo candidato alla carica di "conduttore" di informazioni del futuro. Si tratta del fotone, definito in termini fisici come il quanto di energia della radiazione elettromagnetica. In termini più semplicistici, possiamo considerare il fotone come un singolo impulso luminoso. Già impiegato con successo nella fibra ottica, il fotone potrebbe essere utilizzato anche per la trasmissione di dati e informazioni all'interno di chip (chiamati, non a caso, chip fotonici) caratterizzati da una grande velocità di trasferimento dati e meno soggetti all'effetto Joule. Si tratta, dunque, di chip ad alta efficienza elettrica e capaci di trasportare – almeno nel corso dei primi test – fino a 100 gigabit di dati al secondo (12,5 gigabyte, equivalenti a circa 3 DVD video)

- Nanofogli. Ideati dai tecnici IBM e Samsung, i nanofogli permettono di portare la tecnologia produttiva a 5 nanometri, permettendo così di quadruplicare il numero di transistor oggi presenti all'interno di un chip. Un risultato ottenuto grazie alla modifica delle porte di comunicazione, che circondano i bus di comunicazione interni al chip, garantendo un miglior flusso degli elettroni

Verso l'informatica quantistica

I nuovi chip, però, non sono l'unica strada che tecnici e scienziati informatici stanno percorrendo per continuare a migliorare le prestazioni dei PC. Parallelamente, infatti, molti centri di ricerca stanno puntando con forza sull'informatica quantistica, una branca dell'informatica che si fonda sull'idea che lo scambio di informazioni all'interno di un chip o tra due computer possa avvenire seguendo i principi della fisica quantistica. L'unità minima di informazione, in questo caso, è il qubit o bit quantistico: capace di assumere, in base al principio di indeterminazione di Heisenberg, anche valori intermedi e sovrapposti. Così, se il bit classico può assumere solo il valore "0" o il valore "1", il qubit potrà assumere contemporaneamente il valore di "0" e di "1". In questo modo sarà possibile processare un maggior quantitativo di informazioni al secondo, potenziando in maniera esponenziale le capacità di calcolo dei processori.

23 settembre 2017