Qualche tempo fa, a cavallo tra la fine del primo decennio e l'inizio del secondo decennio del XXI secolo, i ricercatori Google si sono ritrovati di fronte a un grattacapo non da poco: se tutti i suoi utenti avessero utilizzato i servizi di riconoscimento vocale per tre minuti al giorno, sarebbe stata costretta a raddoppiare lo spazio dedicato nei suoi data center per il machine learning, solo per poter soddisfare le crescenti richieste in arrivo da strumenti come Google Now.

La scelta fatta dai vertici di Big G è stata differente: anziché acquistare – o costruire – nuove strutture e nuovi server, ha preferito sviluppare nuove tipologie di hardware dedicate ad applicazioni di machine learning e intelligenza artificiale (come il riconoscimento vocale, ma non solo). Nascono così le TPU (acronimo di Tensor Processing Unit), ovvero delle "normali" CPU progettate e realizzate espressamente per operazioni contraddistinte da un elevato carico di lavoro.

Come funzionano le operazioni di machine learning

Per comprendere le necessità che hanno spinto Google in questa direzione si deve capire, prima di tutto, come funziona il machine learning e il carico di lavoro richiesto per ogni singola operazione. L'esecuzione di un algoritmo di "apprendimento automatico" (traduzione italiana del termine machine learning) si compone di due fasi: una prima di "allenamento" del sistema e creazione di un modello generale all'interno del quale far ricadere i vari casi particolari che si andranno ad analizzare; una seconda di confronto, nel corso della quale si andranno a comparare i singoli dati con il modello creato.

Questa seconda fase, detta inferenziale in gergo tecnico, è quella che produce solitamente il maggior carico di lavoro e per la quale Google – così come tutte le altre aziende del mondo hi-tech – utilizza tecniche di GPU computing. Questo, almeno, sino al momento in cui lo sviluppo delle TPU non è stato completato.

Cosa sono le TPU

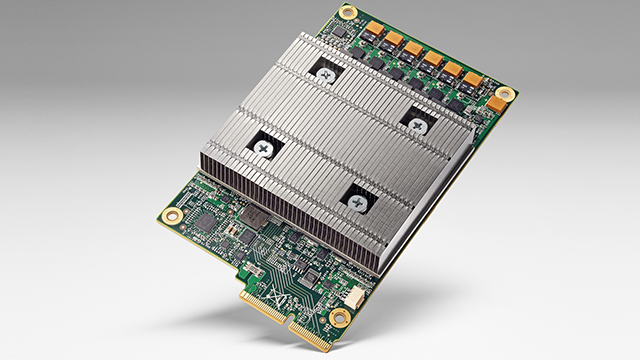

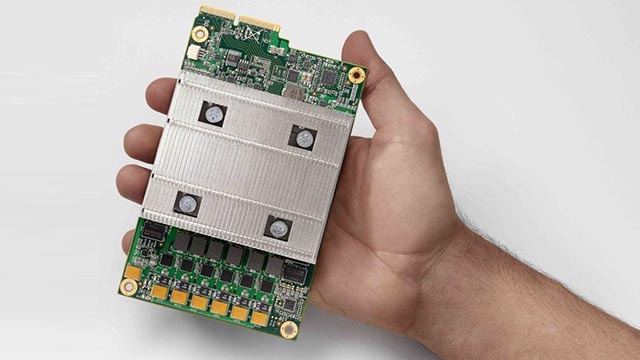

Nate tra il 2008 e il 2012 – ma entrate ufficialmente in "servizio" solo nel 2015 – le Tensor processing unit sono dei chip progettati con lo scopo di ridurre il tempo dedicato alla fase inferenziale all'interno delle reti neurali artificiali utilizzate da Google per il machine learning e l'intelligenza artificiale. Sono state le TPU, tanto per fare un esempio, a guidare le mosse di AlphaGo, l'intelligenza artificiale che ha sfidato e battuto il campione mondiale di Go (gioco di strategia giapponese simile, per alcuni versi, alla nostra Dama) tra aprile e giugno 2017.

Confronto tra TPU, CPU e GPU

Come accennato, sino a qualche anno fa all'interno dei data center di Google – così come quelli di Facebook, Microsoft, Amazon e tutte le altre realtà della Silicon Valley interessate all'intelligenza artificiale – trovavano spazio decine e decine di GPU collegate in parallelo in quelli che sono definiti sistemi di GPU computing. La loro potenza di calcolo non più sufficiente e, soprattutto, il loro elevato consumo energetico le ha rese oramai obsolete e (quasi del tutto) inutilizzabili in ambiti d'avanguardia come il machine learning e l'intelligenza artificiale.

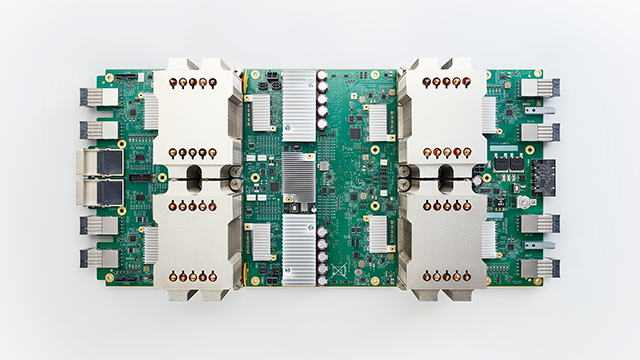

Secondo alcuni dati presentati da Google all'interno di un paper pubblicato su una prestigiosa rivista scientifica, le TPU offrono prestazioni tra le 15 e le 30 volte superiori rispetto a quelle delle GPU più potenti e hanno un'efficienza energetica tra le 30 e le 80 volte superiore rispetto a CPU e GPU. Google, nel frattempo, ha continuato a lavorare sull'architettura di questi chip e nel corso del Google I/O 2017 ha presentato la sua "seconda generazione" di TPU.

Le possibili applicazioni delle TPU

Viste le loro caratteristiche e potenzialità, le Tensor Processing Unit potranno dare grande impulso allo sviluppo delle applicazioni di machine learning e intelligenza artificiale più avanzate. Tra queste non troviamo solo il riconoscimento vocale o la gestione di complessi giochi da tavolo strategici, ma anche le traduzioni istantanee (uno dei settori in più rapido sviluppo) e, soprattutto, il riconoscimento delle immagini ed in particolare il riconoscimento facciale. Insomma, la sicurezza dei dispositivi mobili del futuro (biometria e riconoscimento dei volti) potrebbe essere "alimentata" proprio da un algoritmo elaborato dalle TPU made in Mountain View.